文/Chao Hung Wang

找出並解決使用性問題是改善使用者經驗的基礎。

為達到團隊目標,釐清問題是否為一般性(頻率)以及問題的衝擊程度(嚴重性),是必須分開來處理的。當我們總是直線性地計算一個使用性案例中的問題時,給予問題不同的嚴重性將會是更艱難的挑戰。

在大多的使用性測試中,我們常會發掘許多問題(依經驗為15~30個),當我們有這麼多問題要處理時,給予嚴重性可以幫助團隊把已解決及待解決的問題進行排序。本文將提出五個步驟,幫助團隊以有系統性的方式,給予使用性問題適當的嚴重性排序。

1. 認同選用的嚴重性量尺

給予使用性問題嚴重性有許多種方式,只要能分出嚴重性層次都可以:比方可以是低、中、高;或是複雜一點的1~3分、1~5分或1~7分的量尺。若在團隊中,開發者已經習慣某套嚴重性量尺,那麼就使用它吧。若您開發自己的嚴重性量尺,且可以更清楚地定義出問題的嚴重性及其意義,也是很好的做法。例如,任何可能會造成專案失敗的問題分類在1;表面問題則分類在3。只要團隊的量尺能保有一致性,使用較高或較低的數字來表示專案問題的嚴重性都沒問題。

2. 訓練評估人員

您必須確認所有評估使用性問題的人員都能熟悉所選用的評估量尺,他們也已觀察使用者操作系統,並對領域市場有所有瞭解(如:零售網站、理財app等)。讓資料跟評估人員是一體的,舉例來說,讓一組樣本蒐集而來的問題依團隊現行的量尺來評估嚴重性。新進的評估人員也要透過足夠的訓練,以確保他們能夠一致地評出嚴重性。

3. 至少兩位評估人員獨立作業

「一個不起眼的問題,對於另一個人來說或許是嚴重的。」因此讓評估人員分開作業是必要的。

哪裡有爭議,哪裡就有人不同意。即便是受高度訓練的專家也可能對問題診斷不同意。雇用兩位以上的評估人員將能發掘這些模糊地帶,團隊便能依此判斷潛在的差異。通常人們要達成協議是不可能也並非必要的,反而我們應該透過這些相左的意見,來幫助團隊找出使用性及介面的問題。

4. 達成評估協議

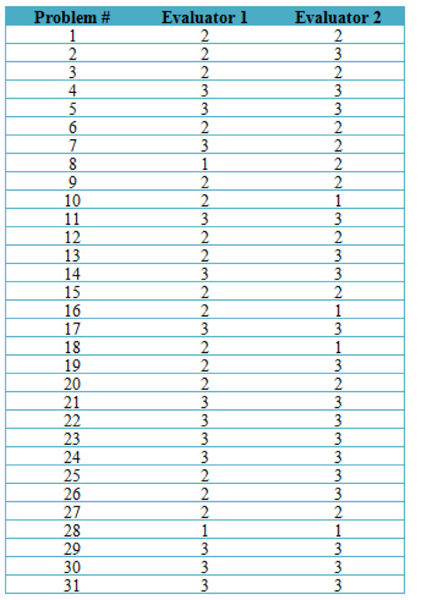

透過計算相關性來找出評估者的共同意見。舉例來說,下表為兩位評估者分別針對某款iPad軟體評估,共計有31個問題被發掘出來,並利用3點式嚴重性量尺:1表示最嚴重問題,3表示次要問題。

皮爾森相關係數(Pearson correlation)是評估共同意見的一個方式。

以本評估為例,r = 0.64,也就是說兩位評估人員給予的意見大致相符。當專家(評估人員)意見分歧時,我們也不希望獲得低度相關的結果,故把r值設在0.5以上做為改進目標。必須重新審視上述兩點:判斷評估人員是否瞭解團隊的量尺,並瞭解他們對於領域市場有足夠的認識。如果我們能夠達到穩定的施測者間信度(inter-rater reliability)(r > 0.8),那麼在評估人員數量的增長上便能趨緩,因為他們在這評量中已經高度重複。

我們發現,在與企業進行同樣介面的評估時,已具高可靠度,那麼使用單一評估人員也是有效的。有些問題在專案版本的迭代不斷出現,那麼不同評估人員給予的差異性,在前面的循環中就可以確立。

5. 調解或均化評量中的差異

在評量中蒐集來自至少兩位的評估人員結果,我們通常會將差異調解或均化。例如在上圖的問題二(Problem #2)中,評估人員1(Evaluator 1)給予問題嚴重性為2(中等嚴重性),而評估人員2給予問題嚴重性為3(最不嚴重),於此兩位評估人員可以互相進行解釋並合理化,商討最終提供給客戶的回答。

另外,我們也可以將問題的嚴重性無條件進位或捨棄,使其增加或減少嚴重性,策略的採取有賴於專案的內容。一般來說,我們會依照現實情況提出合理的嚴重性,此舉便是用以幫助團隊將問題排出優先順序。

原文作者:Jeff Sauro

本文授權來源:How To Assign The Severity Of Usability Problems